【导语:前几日,读过一篇“百度帝国的兴衰史”,文中讲了百度五月份公布了一季度财报,业绩水平整体不佳,甚至出现了从未有过的亏损,消息一出,百度股价应声下跌,唱衰百度之声此起彼伏。落后腾讯、阿里巴巴很多的百度,在此境况之下,愈发显得境遇危险。股价跌破100美元,市值被无数后来者赶超,无数人开始为百度唱起了哀歌,而今,我又看到了百度正在奋力拼搏中寻找生机,真心希望百度不要被历史长河掩没呀!】

图片源于网络

接下来小编带您来看看百度新动态

9月5日,CSDN主办的为期三天的 2019 AI开发者大会(AI ProCon)在北京拉开序幕。大会聚集国内外如百度、华为、Google微软等40多知名科技公司,60位一线技术专家,深入聚焦技术与应用,阐述产业变革。7日下午自然语言处理论坛中,百度NLP主任研发架构师孙宇从自然语言处理的关键难点语义表示技术切入,为到场开发者解析了中英文任务超越谷歌BERT的百度语义理解框架ERNIE。

语言表示是解决自然语言理解的首要问题,语言表示的好坏一定程度决定了计算机处理自然语言的效果。基于此,百度在今年3月首次提出知识增强的语义表示模型ERNIE(Enhanced Representation from kNowledge IntEgration),它在中文NLP任务上表现非凡,百度在多个公开的中文数据集上进行了效果验证,在语言推断、语义相似度、命名实体识别、情感分析、问答匹配等自然语言处理各类任务上,超越了谷歌的语义表示模型BERT的效果。

ERNIE模型通过建模海量数据中的实体概念等先验语义知识,学习真实世界的语义关系。具体来说,百度ERNIE模型通过对词、实体等语义单元的掩码,使得模型学习完整概念的语义表示。相较于 BERT 学习原始语言信号,ERNIE 直接对先验语义知识单元进行建模,增强了模型语义表示能力。

在 BERT 模型中,通过『哈』与『滨』的局部共现,即可判断出『尔』字,模型没有学习『哈尔滨』本身的任何知识。而ERNIE通过学习词与实体的表达,使模型能够建模出『哈尔滨』与『黑龙江』的关系,学到『哈尔滨』是 『黑龙江』的省会以及『哈尔滨』是个冰雪城市。

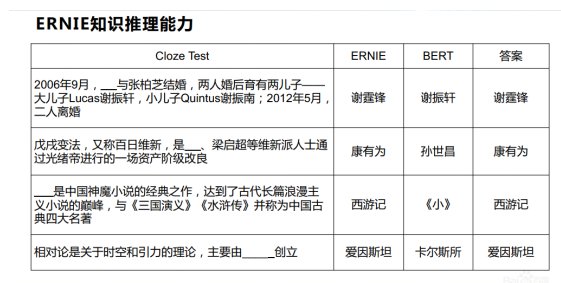

会上,孙宇还用几道趣味填空题验证了ERNIE的知识学习能力。实验将段落中的实体知识去掉,让模型推理其答案。不难看出,ERNIE在基于上下文知识推理能力上表现的更加出色。

ERNIE在自然语言处理领域前进的脚步从未停歇。沉淀短短几个月,升级后的ERNIE于8月正式推出。百度发布的持续学习的语义理解框架ERNIE 2.0在1.0版本中文任务全面超越BERT的基础上,英文任务取得了全新突破,在共计16个中英文任务上超越了BERT和XLNet, 取得了SOTA效果。

孙宇指出,以BERT、XLNet为代表的无监督预训练技术在语言推断、语义相似度、命名实体识别、情感分析等多个自然语言处理任务上在近两年取得了技术突破。基于大规模数据的无监督预训练技术在自然语言处理领域变得至关重要。百度发现,之前的工作主要通过词或句子的共现信号,构建语言模型任务进行模型预训练。例如,BERT通过掩码语言模型和下一句预测任务进行预训练。XLNet构建了全排列的语言模型,并通过自回归的方式进行预训练。

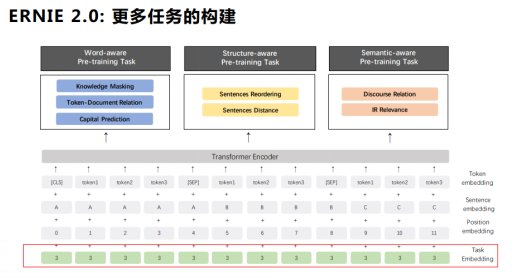

然而,除了语言共现信息之外,语料中还包含词法、语法、语义等更多有价值的信息。例如,人名、地名、机构名等词语概念知识,句子间顺序和距离关系等结构知识,文本语义相似度和语言逻辑关系等语义知识。如果能持续地学习各类任务,模型的效果将会将入一个全新的阶段。

基于此,百度提出可持续学习语义理解框架ERNIE 2.0。该框架支持增量引入词汇(lexical)、语法 (syntactic) 、语义 (semantic) 等3个层次的自定义预训练任务,能够全面捕捉训练语料中的词法、语法、语义等潜在信息。这些任务通过多任务学习对模型进行训练更新,每当引入新任务时,该框架可在学习该任务的同时,不遗忘之前学到过的信息。这也意味着,该框架可以通过持续构建训练包含词法、句法、语义等预训练任务,持续提升模型效果。

依托该框架,百度充分借助飞桨(PaddlePaddle)多机分布式训练优势,利用 79亿tokens训练数据(约1/4的XLNet数据)和64张V100 (约1/8的XLNet硬件算力)训练的ERNIE 2.0预训练模型不仅实现了SOTA效果,而且为开发人员定制自己的NLP模型提供了方案。目前,百度开源了ERNIE 2.0的fine-tuning代码和英文预训练模型。

百度研究团队分别比较了中英文环境上的模型效果。英文上,ERNIE 2.0在自然语言理解数据集GLUE的7个任务上击败了BERT和XLNet。中文上,在包括阅读理解、情感分析、问答等不同类型的9个数据集上超越了BERT并刷新了SOTA。

如今,百度已在自然语言处理领域积累十余年,ERNIE的诞生除了在学术领域的价值,也具备相当重要的产业价值,尤其是在目前国际贸易与科技背景下,拥有与谷歌比肩的语义理解框架意义非凡。ERNIE可以说是百度在自然语言处理方面的重要里程碑,未来百度还将持续深耕该领域,搭起人类与机器“畅所欲言”的沟通桥梁。

(文中部分内容选录自数英DIGITALING,图片源于网络)

新时代鞋服物流与供应链面临的变革和挑战03月07日 20:38

点赞:这个双11,物流大佬一起做了这件事11月22日 21:43

物流管理机构及政策分布概览12月04日 14:10

盘点:2017中国零售业十大事件12月12日 13:57

2017年中国零售电商十大热点事件点评12月28日 09:58